Claude Code

Claude Code 是由 Anthropic 推出的一个 AI 编程助手 / 编程代理(agent‑based AI coding tool),专注于帮助开发者在 终端(Terminal / CLI) 和 IDE 中快速、智能地编写、理解、修改和管理代码。它不仅是一个聊天式助手,而是一个能直接操作代码、运行命令、生成提交(PR)等的 行动型 AI 编程工具。

Anthropic 是一家专注研发大型基础模型(Foundation Models)的 AI 公司,其代表性的产品就是 Claude 系列大模型,类似于 OpenAI 的 ChatGPT。它不仅研发模型,还负责模型的训练和推理服务部署。

Anthropic 芯片

| 任务 | 主要芯片/平台 |

|---|---|

| 训练 Claude 模型 | Google Cloud TPU + AWS Trainium + 可能的 Nvidia GPU |

| 推理部署(线上服务响应) | AWS Inferentia + TPU + 云 GPU |

| 总体策略 | 多云异构架构:根据任务特点匹配最优加速器 |

Claude Code 为什么使用 Anthropic 自研模型表现最好

| 原因 | 说明 |

|---|---|

| 定制优化 | Claude Code 基于 Anthropic 自研的 Claude 模型训练,针对编程语言、代码上下文和逻辑推理做了优化。 |

| 训练数据匹配 | Anthropic 内部训练数据包含大规模开源代码、示例问题和对话数据,与代码生成场景高度契合。 |

| 安全和鲁棒性 | Claude 系列强调安全性和可控性,Claude Code 在代码生成时减少错误、避免危险操作。 |

| 模型架构契合 | Claude 模型架构本身经过优化,可处理长上下文和复杂逻辑,这对代码补全和跨文件分析非常重要。 |

国内限制条件

- VPN

- 需要有效的 Anthropic 账号 + 订阅 / API Key, 境外手机号

- 国际支付方式

国内使用方式-自己搭建中转

这种方式 理论上是可行的,也是大陆用户常用的访问方法,但有几点注意事项:

VPS 选择

- VPS 必须位于海外,并且网络质量稳定,否则延迟高、容易断线。

- 美国住宅 IP 最理想,因为 Claude 会检测请求来源 IP。

安全性

- VPS 上需要配置 Claude Relay 服务,保证 OAuth token 安全。

- 个人搭建要确保不泄露账号信息,否则可能被封号。

复杂度

- 需要处理订阅、支付、VPS 搭建、代理配置等步骤。

- 对普通用户来说操作复杂,但技术上可行。

支付问题仍需解决

- Subscription Block 的环节必须能完成订阅(海外 App Store 礼品卡 + Visa/PayPal)

国内使用方式-商业化中转

接口AI官网创建API Key

配置环境变量

{

# Anthropic API 代理地址(第三方中转:jiekou.ai)

export ANTHROPIC_BASE_URL="https://api.jiekou.ai/anthropic"

# Anthropic API 密钥(由 jiekou.ai 分配,用于鉴权)

export ANTHROPIC_AUTH_TOKEN="API key"

# Claude Code 默认使用的主模型(高质量 / 复杂任务 / 多文件修改)

export ANTHROPIC_MODEL="claude-sonnet-4-5-20250929"

# Claude Code 使用的快速小模型(用于补全、搜索、轻量修改等高频操作)

export ANTHROPIC_SMALL_FAST_MODEL="claude-haiku-4-5-20251001"

# GPT 默认使用的主模型(高质量 / 复杂任务 / 多文件修改)

export ANTHROPIC_MODEL="gpt-5.1-codex"

# GPT 使用的快速小模型(用于补全、搜索、轻量修改等高频操作)

export ANTHROPIC_SMALL_FAST_MODEL="gpt-5-mini"

# gemini 默认使用的主模型(高质量 / 复杂任务 / 多文件修改)

export ANTHROPIC_MODEL="gemini-2.5-pro"

# gemini 使用的快速小模型(用于补全、搜索、轻量修改等高频操作)

export ANTHROPIC_SMALL_FAST_MODEL="gemini-2.5-flash-lite"

# qwen 默认使用的主模型(高质量 / 复杂任务 / 多文件修改)

export ANTHROPIC_MODEL="qwen/qwen3-coder-480b-a35b-instruct"

# qwen 使用的快速小模型(用于补全、搜索、轻量修改等高频操作)

export ANTHROPIC_SMALL_FAST_MODEL="qwen/qwen3-30b-a3b-fp8"

}

充值

进入工程目录,启动 Claude Code 接口

安装 Claude Code

$ curl -fsSL https://claude.ai/install.sh | bash

Setting up Claude Code...

✔ Claude Code successfully installed!

Version: 2.1.14

Location: ~/.local/bin/claude

Next: Run claude --help to get started

✅ Installation complete!

启动

cd your-project claude

会提示输入账号

Welcome to Claude Code v2.1.14

Claude Code can be used with your Claude subscription or billed based on API usage through your Console account.

Select login method:

❯ 1. Claude account with subscription · Pro, Max, Team, or Enterprise

2. Anthropic Console account · API usage billing

模型版本选择

| 系列/版本 | 上下文 | 性能 | 成本 | 使用场景 |

|---|---|---|---|---|

| opus-4-5 | 200k | 高 | 高 | 复杂推理、长文档处理 |

| sonnet-4-5 | 200k | 中高 | 中高 | 对话、文本生成、中等复杂任务 |

| haiku-4-5 | 20k | 低 | 低 | 短文本生成、快速调用、低成本 |

| opus-dd / sonnet-dd | 200k | 高 | 中高 | 需要稳定性、一致性输出场景 |

不同角色的模型选择

| 开发类型 | 建议模型 | 上下文 | 说明 |

|---|---|---|---|

| Android App 开发 | claude-haiku-4-5 / claude-sonnet-4-5 | 20k / 200k | App 问题通常偏业务逻辑、UI、API 调用,haiku 低成本足够;如果一次性处理大量代码或文档,可选 sonnet 200k |

| Android Framework / 系统开发 | claude-opus-4-5 / claude-opus-4-5-dd | 200k | 系统开发问题涉及驱动、HAL、Framework 源码、长文档,opus 高性能和大上下文更适合保证准确性和推理能力 |

claude 计费方式

claude-opus-4-5-20251101

上下文 200,000

$4.5 /百万 tokens(输入)

$22.5 /百万 tokens(输出)

上下文 200,000

一次请求中:输入 tokens + 输出 tokens ≤ 200,000

输入 token

10,000 tokens(比如一段 Framework 源码 + 描述)

10,000 / 1,000,000 × 4.5 = $0.045 美元

输出 token

5,000 tokens(较长的分析 + 代码)

5,000 / 1,000,000 × 22.5 = $0.1125 美元

一次完整调用的真实费用示例

输入:20,000 tokens 输出:5,000 tokens

输入:20,000 / 1,000,000 × 4.5 = $0.09 输出:5,000 / 1,000,000 × 22.5 = $0.1125

总计 ≈ $0.2025 美元

claude-sonnet-4-5-20250929

上下文 200,000

$2.7 /百万 tokens(输入)

$13.5 /百万 tokens(输出)

一次完整调用的真实费用示例

输入:20,000 tokens 输出:5,000 tokens

输入:20,000 / 1,000,000 × 2.7 = $0.054 输出:5,000 / 1,000,000 × 13.5 = $0.0675

总计 ≈ $0.12 美元

OpenAI 费用计算

gpt-5.2-codex

上下文 400,000

$1.75 /百万 tokens(输入)

$14 /百万 tokens(输出)

Gemini 费用计算

gemini-3-pro-preview

上下文 1,048,576

$1.8 /百万 tokens(输入)

$10.8 /百万 tokens(输出)

Qwen

qwen/qwen3-coder-480b-a35b-instruct

上下文 262,144

$0.29/百万 tokens(输入)

$1.2 /百万 tokens(输出)

Deepseek

deepseek/deepseek-v3.1

上下文 163,840

$0.27/百万 tokens(输入)

$1 /百万 tokens(输出)

为什么贵

海外大模型价格高的原因

| 因素 | 说明 |

|---|---|

| 训练成本高 | 训练 GPT‑4、Claude Opus 等模型需要数百甚至上千块 A100 / H100 GPU,训练周期数月,成本动辄千万美元以上 |

| 推理成本高 | 模型参数大(百亿到千亿级),推理时每 token 需要大量算力和显存,尤其是 Claude 输出 token 贵 |

| 服务定位 | 面向企业和高价值场景,强调准确性、可靠性和安全性,价格反映价值和风险成本 |

| 国际支付 / 法律风险 | 数据跨境、API 提供海外服务,计费模式需要维持可盈利运营,同时考虑合规、知识产权、维护成本 |

中国模型便宜的原因

| 因素 | 说明 |

|---|---|

| 算力成本低 | 中国 GPU 价格相对低,电力和机房成本也低,训练成本压缩了 30%–50% 或更多 |

| 企业策略 | 国内公司追求快速用户规模和生态建设,价格低可以吸引开发者和企业大量使用 |

| 优化方向 | 国内模型很多参数量较小(几十到百亿级),或者做了蒸馏、量化,推理成本低 |

| 本地部署 | 可在国内服务器或企业内网部署,减少海外 API 依赖,降低延迟和成本 |

| 政策鼓励 | 政府对国产 AI 支持,包括算力补贴、企业补贴等,间接降低用户成本 |

Claude Code 是否允许接入开源模型

Claude Code 本身并不是只能用 Anthropic 的闭源模型,它 可以 接入某些开源模型或第三方模型,但这需要借助 API 层兼容或代理工具,而不是 Anthropic 官方直接提供的本地开源模型运行。

社区中也出现了一些中间件或代理,如OpenRouter、claude-code-proxy等,它们将 Claude Code 的请求转译成其他模型的接口格式,例如 GPT、Gemini、GLM 等,然后返回响应。 这种方式不需要 Anthropic 的封闭模型就能用 Claude Code 的交互逻辑去调用其他 LLMS。

风险

- Anthropic 可能更新其工具或 API 导致这些兼容方式失效

- 官方 可能不鼓励 在商业环境下用这些代理(取决于服务条款)

Claude Code 对比 Cursor

| 特点 | Claude Code | Cursor |

|---|---|---|

| UI 体验 | CLI | 图形 IDE |

| 交互方式 | 命令/对话 | 编辑器内交互 |

| 代码补全 | X | ✔️ |

| 大规模理解 | ✔️ 强 | ✔️ 中等 |

| 自动任务 | ✔️ 强 | ✔️ 限定 |

| 费用 | 计 token + 订阅 | 订阅制 |

使用场景选择

A. Android App 开发(常规场景)

- 主要使用 Cursor

- 原因:快速、低成本、直接在 IDE 内使用

- 偶尔用 Claude Code

- 对复杂模块或全项目分析,CLI 输出报告或重构建议,再手动应用

B. Framework / HAL / Driver 开发(系统层)

- 主要使用 Claude Code CLI

- 原因:支持大文件、长上下文、复杂依赖分析

- 可在 Android Studio 终端里直接调用 CLI

- 辅助使用 Cursor

- 对单个函数、类的快速优化或生成代码片段时使用

- 成本控制

- Claude Code 输出 token 贵 → 控制输出长度

- 先小范围测试,再批量分析

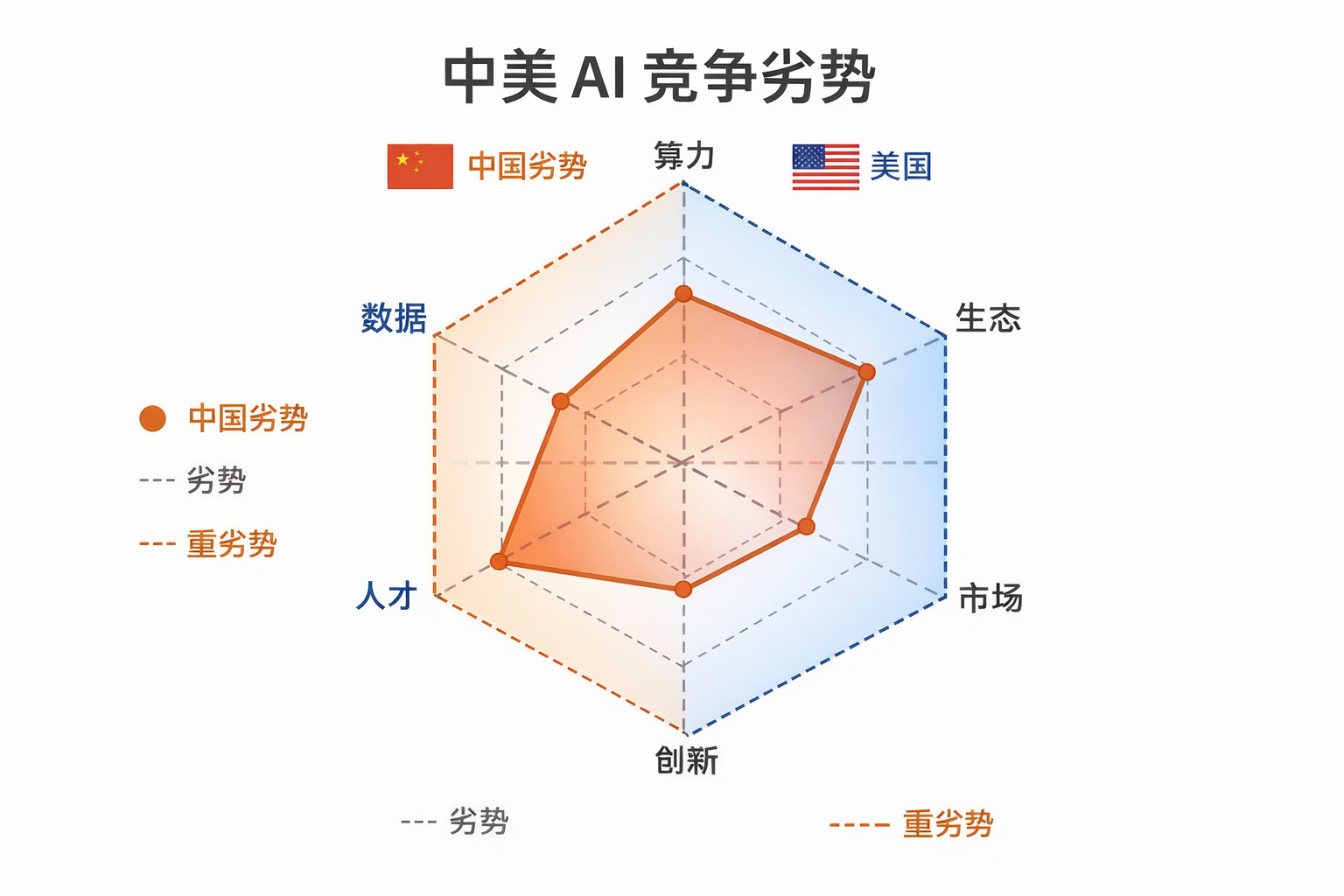

中美竞争